En la carrera por liderar la conducción autónoma, Tesla vuelve a diferenciarse con una apuesta más radical: prescindir de sensores LiDAR y confiar todo exclusivamente en las cámaras y en la inteligencia artificial. Elon Musk lo ha dejado claro en más de una ocasión: la visión humana es suficiente para conducir, y por tanto, un sistema de inteligencia artificial que imite esa capacidad —como su Autopilot Full Self-Driving (FSD)— también lo es. Sin embargo, la industria no parece tan convencida.

Mercedes y Honda: nivel 3 de conducción autónoma

Hasta el momento, solo dos fabricantes han logrado la homologación de sistemas de conducción autónoma de nivel 3 (L3) bajo los estándares internacionales: Mercedes-Benz y Honda. El primero con su Drive Pilot, presente en los modelos Clase S y EQS y homologado para Alemania y Estados Unidos (aquí más información); el segundo, con el Traffic-Jam Pilot del Honda Legend, limitado al mercado japonés.

Ambos sistemas tienen un enfoque común: apuestan por la redundancia de sensores, combinando cámaras, radares y LiDAR para asegurar la máxima fiabilidad en diferentes condiciones.

El nivel 3 de conducción autónoma, según la clasificación de la SAE (Society of Automotive Engineers), permite que el vehículo tome control total de la conducción en situaciones específicas, liberando al conductor de la necesidad de mantener la vista en la carretera. Es un salto cualitativo frente al nivel 2, donde la asistencia aún requiere atención humana constante.

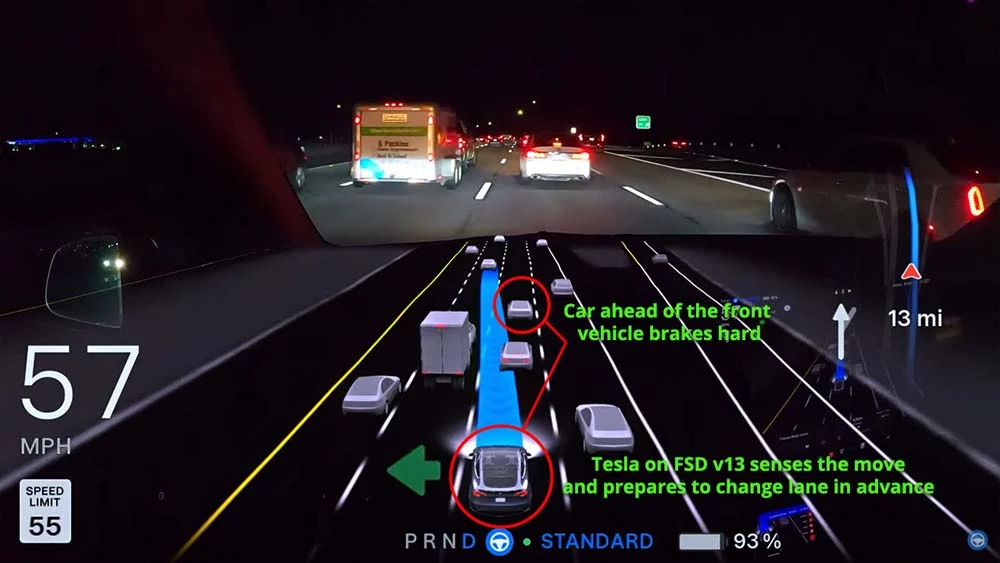

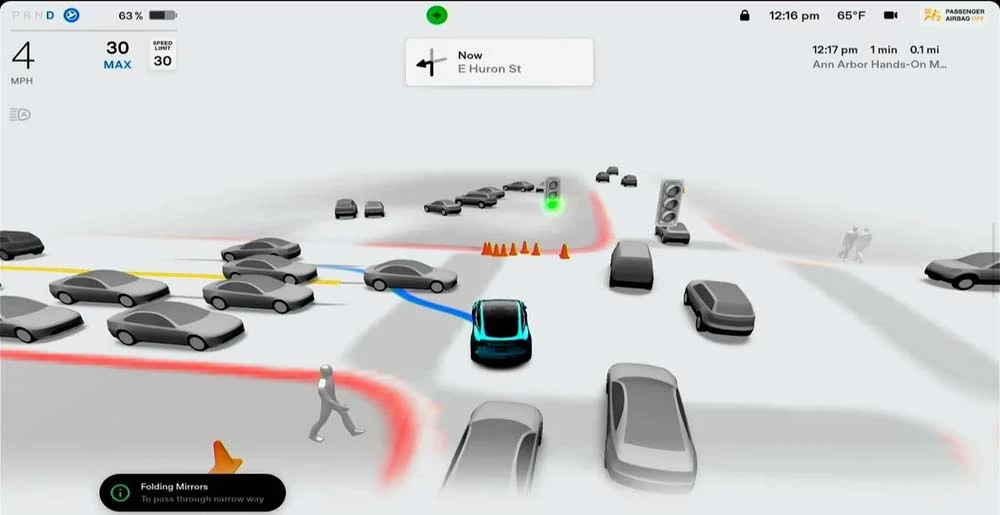

Tesla solo recurre a las cámaras

En ese contexto, Tesla sigue caminando por una senda solitaria. Su FSD se basa únicamente en cámaras y en la potencia de procesamiento de sus redes neuronales, alimentadas con millones de imágenes y vídeos de situaciones reales en carretera. El planteamiento es simple en apariencia: si una persona puede conducir solo con sus ojos, un coche también debería poder hacerlo con cámaras y la inteligencia adecuada.

Pero no todos comparten ese entusiasmo. Li Xiang, fundador de la marca china Li Auto, fue tajante al respecto: “Si Elon Musk condujera en China, entendería por qué es necesario el LiDAR”. En su opinión, la complejidad del entorno urbano chino, con peatones impredecibles, tráfico caótico y señales poco visibles, exige una capacidad de detección que las cámaras, por sí solas, no pueden ofrecer.

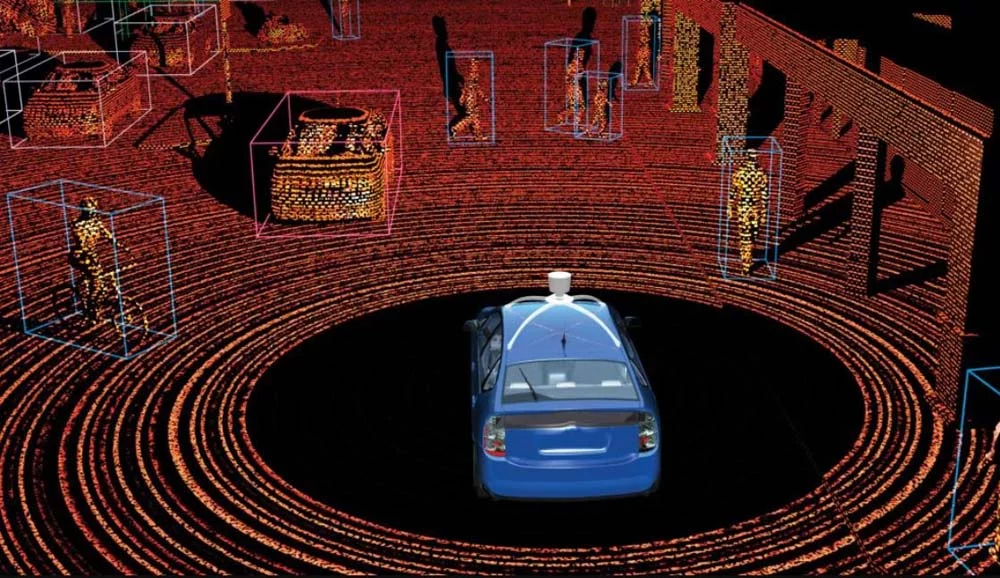

El sistema LiDAR es más completo y seguro

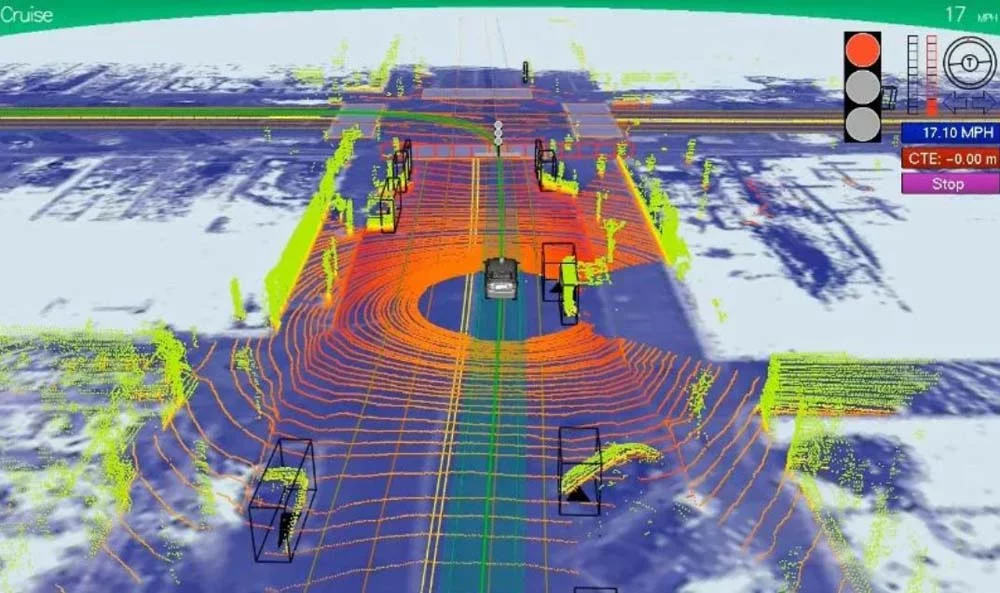

El LiDAR —acrónimo de Light Detection and Ranging— es un sensor que emite pulsos láser infrarrojos y mide el tiempo que tarda la luz en regresar tras rebotar en un objeto. De este modo, genera un mapa tridimensional preciso del entorno, con un alcance de hasta 250 metros, independientemente de la luz ambiental o de las condiciones meteorológicas. Funciona igual de bien de noche que de día, y es especialmente útil en situaciones de lluvia, nieve o cuando la visibilidad es baja.

En sistemas como los de Mercedes-Benz y Honda, el LiDAR se combina con otros sensores para crear una redundancia funcional. Así, si un sensor falla o proporciona datos imprecisos, los demás pueden compensarlo. Este enfoque es visto por muchos como la vía más segura para lograr una conducción verdaderamente autónoma.

Las cámaras bien, pero con lluvia o suciedad…

Un estudio reciente de Carglass España sobre los sistemas ADAS y el papel del LiDAR en los niveles 2 y 3 de conducción autónoma destaca justamente esto: que la eficacia de los sistemas basados solo en cámaras disminuye significativamente en condiciones adversas, como lluvia intensa o parabrisas sucios. El LiDAR, por su parte, mantiene su rendimiento incluso en estas situaciones.

Las normativas internacionales, como las establecidas por la UNECE, no exigen explícitamente el uso de LiDAR, pero sí demandan redundancia en la percepción del entorno y un rendimiento fiable en todo tipo de condiciones. Esto ha permitido que algunos fabricantes, mediante una combinación de sensores heterogéneos, logren las aprobaciones necesarias en Europa, EE.UU. y Japón.

Tesla todavía no tiene validación formal L3

Tesla, al carecer de esa diversidad de sensores, enfrenta un desafío adicional: debe demostrar mediante simulaciones, estadísticas y pruebas que su sistema basado exclusivamente en cámaras e inteligencia artificial es igual de seguro en todas las circunstancias. Hasta ahora, no ha conseguido esa validación formal para L3, aunque sigue insistiendo en que está muy cerca de lograrlo.

Los sistemas con múltiples sensores implican una mayor complejidad técnica. Integrar datos de LiDAR, radar y cámaras requiere un procesamiento masivo y casi instantáneo —menos de 100 milisegundos— para evitar errores en la toma de decisiones del vehículo. Esto obliga a los fabricantes a incorporar hardware con potencias de cálculo descomunales, que pueden superar los 2.000 TOPS (Tera Operaciones por Segundo), y redes de memoria de altísimo ancho de banda.

Tesla, al centrarse solo en cámaras, reduce esta carga computacional. Su sistema necesita menos energía, menos refrigeración y menos cableado. Pero también asume el riesgo de no contar con un ‘plan B’ en caso de que la cámara falle o no vea bien.

¿Y si los sensores no se ponen de acuerdo?

En los sistemas con sensores múltiples, cuando la información es contradictoria, entran en juego algoritmos avanzados de fusión y validación. Desde filtros de Kalman, que predicen trayectorias, hasta modelos probabilísticos bayesianos o técnicas de ponderación como la de Dempster-Shafer, en la que cada dato se evalúa y se cruza para generar una interpretación coherente del entorno.

Mercedes duplica las soluciones

Mercedes-Benz incluso duplica la cadena de procesamiento: una para LiDAR y radar, y otra para cámaras. Si ambas cadenas coinciden, se sigue adelante. Si hay discrepancias, el sistema toma la opción más conservadora. Y si el conflicto no puede resolverse, se desactiva el modo autónomo y el vehículo vuelve al control del conductor (nivel 2).

Uno de los argumentos más repetidos por Tesla es que los sensores LiDAR comprometen el diseño y la aerodinámica de sus vehículos. Aunque los modelos más avanzados de LiDAR de conducción autónoma L5 se instalan en el techo y giran constantemente para ofrecer una visión de 360°, los sensores para nivel 3 son más compactos y fijos, con ángulos de visión de 120° orientados hacia el frente y los laterales del coche.

La siguiente generación irá aún más lejos: sensores frontales integrados tras el parabrisas, invisibles desde el exterior y sin impacto visual. Según Carglass España, estos sensores, a diferencia de las cámaras ADAS, no requieren recalibración tras el reemplazo del cristal, aunque sí un reseteo puntual.

El futuro se disputa sensor a sensor

Mientras la industria parece avanzar hacia una combinación de tecnologías, la marca norteamericana insiste en que menos es más. La pregunta no es solo quién llegará primero al nivel 3 con homologación global, sino qué filosofía será la que defina el futuro de la conducción autónoma: la visión minimalista y algorítmica de Musk, o la apuesta por la redundancia tecnológica del resto del sector.